I colossi della tecnologia stanno pagando milioni di dollari alle fabbriche di troll, alimentando il deterioramento degli ecosistemi informativi in tutto il mondo.

di Karen Hao

Birmania, marzo 2021

Un mese dopo la caduta del governo democratico, un video di Facebook live (si veda figura 1) ha mostrato centinaia di persone che protestavano contro il golpe militare per le strade di Myanmar. Ha avuto quasi 50.000 condivisioni e oltre 1,5 milioni di contatti in un paese con poco più di 54 milioni di abitanti. Gli osservatori, impossibilitati a seguire gli eventi sul campo, hanno utilizzato il filmato insieme a centinaia di altri feed dal vivo per tracciare la situazione in corso.

Ma meno di un giorno dopo, lo stesso video sarebbe stato trasmesso di nuovo più volte, in ognuna delle quali si dichiarava ancora di essere in diretta. Nel mezzo di una serissima crisi politica, non c’era più modo di distinguere tra il vero e il falso.

Nel 2015, sei dei 10 siti web più visitati su Facebook in Myanmar erano legati a media ufficiali, secondo i dati di CrowdTangle, una piattaforma gestita da Facebook. Un anno dopo, l’azienda (che recentemente è stata rinominata Meta) ha offerto l’accesso globale a Instant Articles, un programma che gli editori utilizzano per monetizzare i propri contenuti.

Un anno dopo il lancio, gli editori ufficiali erano scesi a due. Nel 2018 erano pari a zero. Gli utenti di Facebook si erano spostati sui cosiddetti siti acchiappaclic. In un paese in cui questa azienda è sinonimo di Internet, i contenuti di basso livello hanno sopraffatto altre fonti di informazione.

È stato durante questo rapido degrado dell’ambiente digitale del Myanmar che un gruppo militante dei Rohingya, una minoranza etnica prevalentemente musulmana, ha attaccato e ucciso una dozzina di membri delle forze di sicurezza, nell’agosto del 2017. Quando la polizia e l’esercito hanno iniziato a reprimere i Rohingya, la propaganda anti-musulmana con una lunga serie di fake è diventata virale. Si è sostenuto che i musulmani erano armati, che si stavano radunando in una folla di 1.000 persone, che erano pronti a uccidere.

Non è ancora chiaro oggi se le fake news provenissero principalmente da attori politici o da persone con motivazioni finanziarie. Ma in entrambi i casi, l’enorme volume di notizie false e acchiappaclic ha agito come combustibile sulle fiamme di tensioni etniche e religiose già pericolosamente alte. Ha spostato l’opinione pubblica e ha intensificato il conflitto, che alla fine ha portato alla morte di 10.000 Rohingya, secondo stime prudenti, e alla diaspora di altri 700.000.

Nel 2018, un’indagine delle Nazioni Unite ha stabilito che la violenza contro i Rohingya costituiva un genocidio e che Facebook aveva svolto un “ruolo determinante” nelle atrocità. Mesi dopo, l’azienda ha ammesso di non aver fatto abbastanza per impedire che la sua piattaforma venisse utilizzata per fomentare la divisione e incitare alla violenza offline”.

Nelle ultime settimane, le rivelazioni dei Facebook Papers, una raccolta di documenti interni forniti al Congresso e a un consorzio di organizzazioni di notizie dall’informatrice Frances Haugen, hanno riaffermato ciò che le organizzazioni per i diritti civili affermano da anni: l’amplificazione algoritmica di contenuti infiammatori di Facebook, insieme alla sua incapacità di dare priorità alla moderazione dei contenuti al di fuori degli Stati Uniti e dell’Europa, ha alimentato l’incitamento all’odio e la disinformazione, destabilizzando pericolosamente i paesi di tutto il mondo.

Ma c’è un pezzo cruciale che manca alla storia. Facebook non sta solo amplificando la disinformazione, la sta anche finanziando. Un’indagine di “MIT Technology Review”, basata su interviste ad esperti, analisi di dati e documenti che non sono stati inclusi nei Facebook Papers, ha scoperto che Facebook e Google stanno pagando milioni di dollari pubblicitari per finanziare i siti acchiappaclic, alimentando il deterioramento degli ecosistemi informativi nel mondo.

L’anatomia di una fabbrica di troll

Facebook ha lanciato il suo programma Instant Articles nel 2015 con una manciata di editori statunitensi ed europei. L’azienda ha presentato il programma come un modo per migliorare i tempi di caricamento degli articoli e creare un’esperienza utente più fluida. Perlomeno, questa era la versione ufficiale. Ma la mossa ha anche attirato i soldi spesi a scopo pubblicitario da Google. Prima di Instant Articles, gli articoli pubblicati su Facebook reindirizzavano a un browser, dove si aprivano sul sito web dell’editore. Il fornitore di annunci, di solito Google, guadagnava quindi su qualsiasi visualizzazione o clic dell’annuncio.

Con il nuovo schema, gli articoli si aprivano direttamente all’interno dell’app di Facebook, vale a dire la proprietaria dello spazio pubblicitario. Se anche un editore partecipante avesse optato per la monetizzazione con la rete pubblicitaria di Facebook, chiamata Audience Network, l’azienda poteva inserire annunci nelle storie dell’editore e ottenere il 30 per cento delle entrate.

Instant Articles è rapidamente caduto in disgrazia con la sua schiera di grandi editori mainstream. Per loro, i pagamenti non erano abbastanza alti rispetto ad altre forme di monetizzazione disponibili. Ma questo non era vero per gli editori nel Sud del mondo, che Facebook ha iniziato ad accettare nel programma nel 2016. Nel 2018, l’azienda ha riferito di aver pagato 1,5 miliardi di dollari a editori e sviluppatori di app (che possono anche far parte di Audience Network). Nel 2019, la cifra era salita a diversi miliardi di dollari.

All’inizio, Facebook ha eseguito pochi controlli di qualità sui tipi di editori che stavano aderendo al programma. Inoltre, il design della piattaforma non ha penalizzato sufficientemente gli utenti per la pubblicazione di contenuti copiati sulle pagine di Facebook, anzi, ne ha premiato il comportamento. La pubblicazione dello stesso articolo su più pagine può raddoppiare il numero di utenti che hanno fatto clic su di esso e generare entrate pubblicitarie. Le fabbriche acchiappaclic di tutto il mondo hanno colto questo difetto come una strategia, che usano ancora oggi.

Una fabbrica acchiappaclic (si veda figura 2) crea uno o più siti web per la pubblicazione di contenuti prevalentemente plagiati. Li registra con Instant Articles e passa ad Audience Network, che consente agli editori di mostrare inserzioni pubblicitarie. Quindi pubblica questi articoli su un gruppo di decine di pagine di Facebook alla volta.

Gli acchiappaclic sono spuntati in Myanmar durante la notte. Con la giusta ricetta per produrre contenuti coinvolgenti ed evocativi, sono in grado di generare migliaia di dollari al mese di entrate pubblicitarie, o 10 volte lo stipendio medio mensile, pagato loro direttamente da Facebook (si veda link). Un documento interno dell’azienda, riportato per la prima volta da “MIT Technology Review”, mostra che Facebook era a conoscenza del problema già nel 2019. L’autore, l’ex data scientist di Facebook Jeff Allen, ha scoperto che queste tattiche avevano consentito alle fabbriche acchiappaclic in Macedonia e Kosovo di raggiungere quasi mezzo milione di americani all’anno prima delle elezioni del 2020.

La stessa logica si è fatta strada su Instant Articles e Ad Breaks, un programma di monetizzazione simile per l’inserimento di annunci nei video di Facebook. A un certo punto, ben il 60 per cento dei domini registrati in Instant Articles utilizzava le tattiche di scrittura di spam impiegate dalle fabbriche acchiappaclic, afferma il rapporto. Allen, vincolato da un accordo di riservatezza con Facebook, non ha commentato la notizia.

L’azienda ha anche iniziato a lanciare più programmi di monetizzazione per intercettare nuovi flussi di entrate. Oltre alle interruzioni pubblicitarie per i video, si sono introdotti la monetizzazione IGTV per Instagram e gli annunci in-stream per i video live. “Dopo la spinta sconsiderata per la crescita degli utenti che abbiamo visto, si è iniziato ad assistere allo stesso meccanismo per la crescita degli editori”, afferma Victoire Rio, una ricercatrice impegnata nel campo dei diritti digitali.

“MIT Technology Review” ha scoperto che il problema si sta verificando su scala globale. Sono sorte migliaia di iniziative acchiappaclic, principalmente nei paesi in cui i pagamenti di Facebook forniscono una fonte di reddito più ampia e stabile rispetto ad altre forme di lavoro disponibili. Alcuni sono gruppi di persone mentre altri sono singoli individui, aiutati da strumenti automatizzati a basso costo che permettono loro di creare articoli su larga scala, diffondere video in diretta e gestire account Instagram, che monetizzano direttamente o utilizzano per indirizzare più traffico ai loro siti.

Anche Google ha le sue responsabilità. Il suo programma AdSense ha alimentato i siti di fake con sede in Macedonia e Kosovo che hanno preso di mira il pubblico americano in vista delle elezioni presidenziali del 2016. Ed è AdSense che sta incentivando i nuovi creatori di troll su YouTube a pubblicare contenuti oltraggiosi e disinformazione virale.

Molti autori di fake oggi ora monetizzano sia con Instant Articles che con AdSense, ricevendo pagamenti da entrambe le aziende. Inoltre, poiché gli algoritmi di Facebook e YouTube potenziano tutto ciò che interessa agli utenti, hanno creato un ecosistema di informazioni in cui i contenuti che diventano virali su una piattaforma vengono spesso riciclati sull’altra per massimizzare la diffusione e le entrate.

“Questi attori non esisterebbero se non fosse per le piattaforme”, dice Rio. In risposta alle prove dettagliate che sono state fornite di questo comportamento, il portavoce di Meta Joe Osborne ha contestato i risultati di “MIT Technology Review”, affermando che il problema è stato travisato. “Indipendentemente da ciò”, ha affermato, “abbiamo investito nella creazione di nuove soluzioni per affrontare queste tematiche complesse da molti anni e continueremo a farlo”.

Google ha confermato che il comportamento ha violato le sue politiche e ha chiuso tutti i canali YouTube che “MIT Technology Review” ha identificato come diffusori di disinformazione. “Lavoriamo senza sosta per proteggere gli utenti dalle reti acchiappaclic o dai contenuti fuorvianti sulle nostre piattaforme e abbiamo investito molto in sistemi progettati per promuovere i contenuti autorevoli”, ha affermato Ivy Choi, il portavoce di YouTube.

Le fabbriche di troll non prendono di mira solo i loro paesi d’origine. Seguendo l’esempio dei siti di fake della Macedonia e del Kosovo, i nuovi operatori si sono resi conto che non hanno bisogno di comprendere né il contesto locale di un paese né la sua lingua per trasformare lo sdegno politico in reddito.

“MIT Technology Review” ha collaborato con Allen, che ora guida un’organizzazione no profit chiamata Integrity Institute, che conduce ricerche sull’abuso della piattaforma, per identificare possibili autori di fake su Facebook. Ci si è concentrati sui siti di Cambogia e Vietnam, due dei paesi in cui sono attivi i troll sulla situazione in Myanmar.

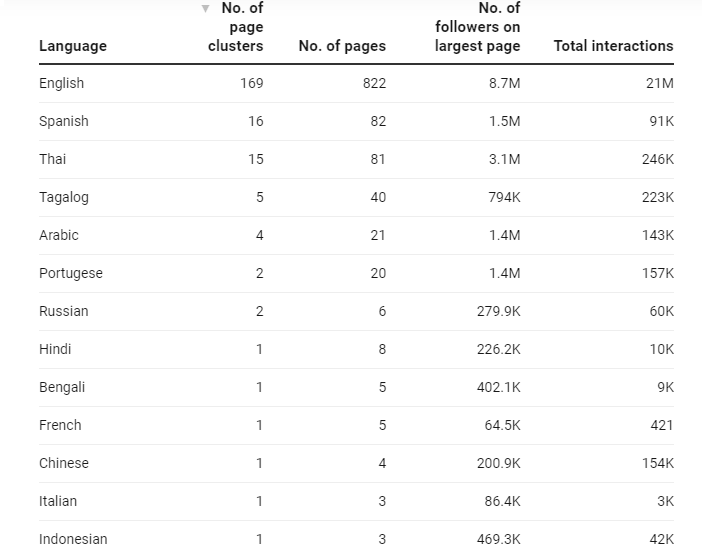

Sono stati ottenuti dati da CrowdTangle, il cui team di sviluppo è stato sciolto all’inizio di quest’anno, e dagli elenchi di editori di Facebook, che registrano chi è inserito nei programmi di monetizzazione. Allen ha scritto un algoritmo di clustering personalizzato per trovare pagine che pubblicano contenuti in modo altamente coordinato e che si rivolgono a parlanti di lingue utilizzate principalmente al di fuori dei paesi in cui sono prodotti i contenuti. Sono quindi stati analizzato quali cluster avevano almeno una pagina registrata in un programma di monetizzazione o stavano promuovendo costantemente i contenuti di una pagina registrata con un programma.

Sono state trovate oltre 2.000 pagine in entrambi i paesi coinvolti in questo comportamento simile a quello dei creatori di troll. Il calcolo potrebbe essere sottostimato perché non tutte le pagine di Facebook sono tracciate da CrowdTangle e molte probabilmente raggiungono ancora più utenti. Nel suo rapporto del 2019, Allen ha scoperto che il 75 per cento degli utenti che sono stati esposti a contenuti acchiappaclic provenienti da Macedonia e Kosovo non aveva mai seguito nessuna delle pagine. Il sistema di raccomandazione dei contenuti di Facebook li aveva invece inseriti nei loro feed di notizie (si vedano tabelle 3 e 4).

Quando “MIT Technology Review” ha inviato a Facebook un elenco di queste pagine e una spiegazione dettagliata della metodologia adottata, Osborne ha definito l’analisi “difettosa”. “Anche se alcune pagine potrebbero essere state presenti nei nostri elenchi di editori, molte di loro non hanno di fatto monetizzato su Facebook”, ha affermato. In realtà, questi numeri non indicano che tutte queste pagine abbiano generato entrate pubblicitarie. Si tratta invece di una stima, basata sui dati che Facebook ha reso pubblicamente disponibili, del numero di pagine associate alle fabbriche di troll in Cambogia e Vietnam che Facebook ha reso idonee a monetizzare sulla piattaforma.

Osborne ha anche confermato che altre pagine simili in Cambogia si erano registrate direttamente con uno dei programmi di monetizzazione di Facebook. Nell’analisi di “MIT Technology Review” si è riscontrato che il 35 per cento delle pagine nei cluster presi in considerazione lo aveva fatto negli ultimi due anni. L’altro 65 per cento avrebbe indirettamente generato entrate pubblicitarie promuovendo i contenuti dalla pagina registrata presso un pubblico più ampio. Osborne ha affermato che in effetti circa la metà delle pagine che sono state esaminate, circa 150, si erano registrate direttamente a un certo punto con un programma di monetizzazione, principalmente Instant Articles.

Poco dopo i contatti avuti con Facebook da parte di “MIT Technology Review”, gli autori di troll in Myanmar hanno iniziato a lamentarsi nei forum online del fatto che le loro pagine erano state cancellate da Instant Articles. Osborne non ha risposto alle domande su questo argomento. L’azienda dice che ha costantemente cercato di eliminare questi creatori di contenuti dai suoi programmi. Per esempio, solo 30 delle pagine gestite dalla Cambogia stanno ancora monetizzando, ha affermato Osborne.

Ma i dati degli elenchi di editori di Facebook mostrano che l’applicazione è spesso ritardata e incompleta: le pagine di troll riescono a rimanere nei programmi di monetizzazione per centinaia di giorni prima di essere rimosse. Gli stessi attori creeranno anche nuove pagine una volta che le vecchie saranno demonetizzate.

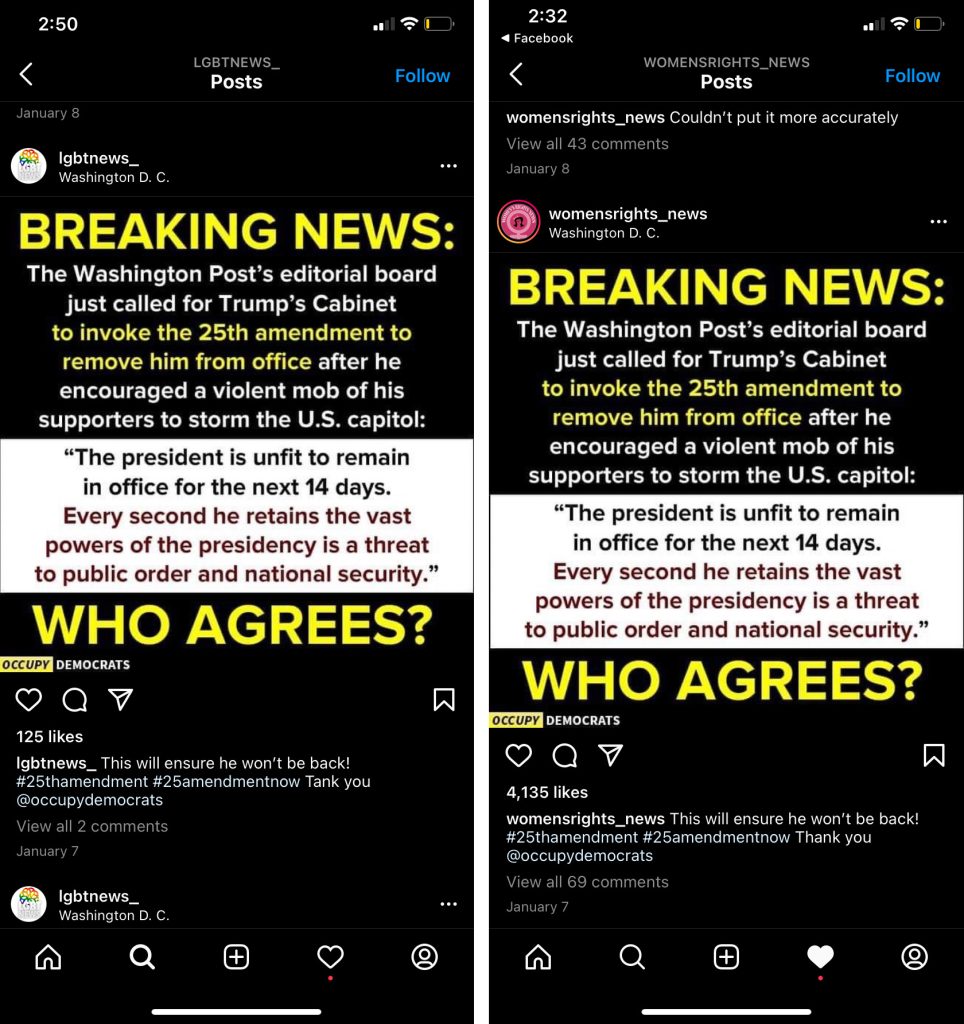

Utilizzando la stessa metodologia, “MIT Technology Review” ha anche trovato più di 400 pagine gestite dall’estero rivolte principalmente a un pubblico statunitense in gruppi che sono apparsi negli elenchi di editori di Facebook negli ultimi due anni (non sono state incluse pagine di paesi la cui lingua principale è l’inglese). Il set include un cluster di monetizzazione legato in parte dalla Macedonia e rivolto alle donne e alla comunità LGBTQ.

Ha otto pagine Facebook, di cui due verificate con oltre 1,7 milioni e 1,5 milioni di follower rispettivamente, e pubblica contenuti da cinque siti web, ciascuno registrato con Google AdSense e Audience Network (si veda figura 5). Ha anche tre account Instagram, che monetizzano attraverso negozi di articoli da regalo e collaborazioni, indirizzando gli utenti agli stessi siti Web in gran parte plagiati. Gli amministratori delle pagine Facebook e degli account Instagram non hanno risposto alle richieste di commento.

Choi ha affermato che in passato Google ha rimosso gli annunci AdSense da centinaia di pagine di questi siti a causa di violazioni delle norme, ma che i siti stessi possono ancora monetizzare in base alle regolari revisioni dell’azienda. Sebbene sia possibile che i macedoni che gestiscono le pagine si preoccupino davvero della politica degli Stati Uniti e dei diritti delle donne e delle persone LGBTQ, il contenuto sta innegabilmente generando entrate. Ciò significa che i contenuti che promuovono sono molto probabilmente guidati dai risultati dell’algoritmo del feed di notizie di Facebook.

L’attività di una singola pagina o di un gruppo di pagine potrebbe non sembrare significativa, afferma Camille François, ricercatrice della Columbia University che studia le campagne di disinformazione organizzate sui social media. Ma quando centinaia o migliaia di attori stanno facendo la stessa cosa, amplificando lo stesso contenuto e raggiungendo milioni di spettatori, il confronto pubblico ne risulta condizionato. “Ciò che le persone vedono come una semplice conversazione su un argomento può in realtà essere qualcosa di completamente diverso”, afferma François.

Osborne ha affermato che Facebook ha creato numerosi nuovi protocolli di applicazione negli ultimi due anni per affrontare questo problema, tra cui penalizzare le pagine eseguite da un paese che si comportano come se fossero localizzate in un altro, nonché penalizzare le pagine che costruiscono un pubblico sul base di un argomento e poi ne trattano un altro. Ma sia Allen che Rio affermano che le azioni dell’azienda non sono riuscite a colmare le lacune fondamentali nelle politiche e nei progetti della piattaforma, vulnerabilità che stanno alimentando una crisi informatica globale. “La situazione ora sta penalizzando prima di tutto i paesi al di fuori degli Stati Uniti, ma presenta un enorme rischio anche per gli Stati Uniti a lungo termine”, spiega Rio.

La disinformazione non è mai innocua

In risposta al rapporto iniziale di “MIT Technology Review” sul rapporto interno 2019 di Allen, che è stato pubblicato integralmente, David Agranovich, direttore del Global Threat Breaking di Facebook, ha twittato: “Le pagine a cui si fa riferimento qui, basate sulla nostra ricerca del 2019, sono definite spam per monetizzare, non operazioni di influenza aperta. Entrambe queste sono sfide serie, ma sono diverse. Confondere le cose non aiuta nessuno”. Osborne ha ripetuto che “MIT Tecnology Review” stava fondendo i due gruppi.

Ma gli esperti di disinformazione dicono che è fuorviante tracciare una linea rigida tra spammer motivati finanziariamente e operazioni di influenza politica. C’è una distinzione nell’intento: gli spammer motivati finanziariamente sono agnostici riguardo al contenuto che pubblicano. Vanno ovunque ci siano clic e denaro, lasciando che l’algoritmo del feed di notizie di Facebook detti quali argomenti tratteranno in seguito. Le operazioni politiche sono invece mirate a promuovere un’agenda specifica.

Ma in pratica non cambia nulla perché nella tattica e nell’impatto spesso sono uguali. In un giorno normale, un sito di troll motivato finanziariamente potrebbe essere popolato da notizie su celebrità, simpatici animali o storie altamente emotive, tutti driver di traffico affidabili. Quindi, quando si verificano disordini politici, il sito si sposta verso notizie iperpartigiane, disinformazione e esche oltraggiose perché ottiene più coinvolgimento.

Il cluster di pagine macedone costituisce un ottimo esempio. Il più delle volte il contenuto promuove i diritti delle donne e della comunità LGTBQ, ma nel periodo di eventi come le elezioni del 2020, l’insurrezione del 6 gennaio e l’approvazione della legge antiabortista del Texas, il cluster ha amplificato il contenuto politico particolarmente mirato. Molti dei suoi articoli sono stati ampiamente diffusi da pagine legittime con un enorme seguito, tra cui quelle gestite da Occupy Democrats, Union of Concerned Scientists e Women’s March Global (si vedano figure 6 e 7).

Chi cerca di esercitare un’influenza politica, nel frattempo, potrebbe pubblicare contenuti su celebrità e animali per costruire pagine Facebook con un ampio seguito e dedicarsi successivamente a eventi politici delicati, capitalizzando l’enorme pubblico già a disposizione. Gli operatori politici a volte pagano anche spammer motivati finanziariamente per trasmettere propaganda sulle loro pagine Facebook o acquistare pagine per riutilizzarle per campagne di influenza. Rio è a conoscenza di un mercato nero in cui le fabbriche di troll possono vendere il loro vasto pubblico di Facebook.

In altre parole, le pagine sembrano innocue, ma non lo sono. “Abbiamo autorizzato attori non autentici ad accumulare un grande seguito per scopi in gran parte sconosciuti”, ha scritto Allen nel rapporto. Questo cambiamento è avvenuto molte volte in Myanmar, in particolare durante la crisi dei Rohingya e ancora prima e dopo il colpo di stato militare di quest’anno (quest’ultimo è stato accelerato da eventi molto simili a quelli che hanno portato all’insurrezione statunitense del 6 gennaio, comprese le diffuse affermazioni false sulle elezioni rubate).

Nell’ottobre del 2020, Facebook ha chiuso un certo numero di pagine e gruppi impegnati in creazione di troll, coordinati in Myanmar. In un’analisi di tali risorse, Graphika, un’azienda di ricerca che studia la diffusione delle informazioni online, ha scoperto che le pagine si concentravano principalmente su notizie di celebrità e pettegolezzi, ma diffondevano propaganda politica, pericolosa retorica anti-musulmana e disinformazione sul covid-19 durante i momenti di crisi. Decine di pagine avevano più di 1 milione di follower ciascuna, con la più grande che superava i 5 milioni.

Lo stesso fenomeno si è verificato nelle Filippine in vista delle elezioni del 2016 del presidente Rodrigo Duterte, spesso paragonato a Donald Trump per la sua politica populista, la sua retorica roboante e le sue inclinazioni autoritarie. Durante la sua campagna, una fabbrica di troll, registrata formalmente come Twinmark Media, è passata dalla copertura di celebrità e intrattenimento alla promozione di lui e della sua ideologia.

A quel tempo, era opinione diffusa che i politici avessero contattato Twinmark per condurre una campagna di influenza. Ma nelle interviste con giornalisti e ricercatori, gli ex dipendenti di Twinmark hanno ammesso che stavano semplicemente inseguendo il profitto. Si erano resi conto che i contenuti pro-Duterte avevano grande seguito durante un’accesa elezione e hanno persino pagato celebrità e influencer per condividere i loro articoli per ottenere più clic e generare più entrate pubblicitarie, secondo una ricerca degli studiosi di media e comunicazione Jonathan Ong e Jason Vincent A. Cabañes.

Negli ultimi mesi della campagna, Duterte ha dominato il confronto politico sui social media. Facebook stesso lo ha nominato “re indiscusso dei contenuti su Facebook” quando ha scoperto che era oggetto del 68 per cento di tutti gli interventi relativi alle elezioni, rispetto al 46 per cento del suo rivale più accreditato. Tre mesi dopo l’elezione, Maria Ressa, CEO della società di media Rappler, che ha vinto il Premio Nobel per la pace quest’anno per il suo lavoro sulla disinformazione, ha pubblicato un articolo che spiega come un concerto di acchiappaclic e propaganda su Facebook “sposta l’opinione pubblica su questioni chiave”.

Nel 2019, Facebook ha chiuso 220 pagine, 73 suoi account e 29 account Instagram collegati a Twinmark Media. Fino ad allora, Facebook e Google avevano già corrisposto alle fabbriche di troll circa 8 milioni di dollari. Né Facebook né Google hanno confermato tale importo. Osborne di Meta ha contestato l’ipotesi che Facebook abbia influenzato le elezioni.

Una minaccia in evoluzione

Secondo il rapporto interno di Allen, Facebook si è impegnata ad eliminare i troll da Instant Articles e da AD Breaks nella prima metà del 2019. In particolare, ha iniziato a controllare gli editori per l’originalità dei contenuti e a demonetizzare coloro che hanno pubblicato contenuti in gran parte non originali. Ma questi controlli automatizzati sono limitati. Si concentrano principalmente sulla valutazione dell’originalità dei video e non, per esempio, sull’eventuale plagio di un articolo.

Anche se lo facessero, tali sistemi sarebbero validi solo quanto le capacità di intelligenza artificiale dell’azienda in una data lingua. I paesi con lingue non prioritarie per la comunità di ricerca sull’AI ricevono molta meno attenzione, se non addirittura nulla. “Nel caso dell’Etiopia ci sono 100 milioni di persone e sei lingue. Facebook supporta solo due di queste lingue per i sistemi di integrità”, ha detto Haugen durante la sua testimonianza al Congresso.

Rio sostiene che ci sono anche scappatoie nell’applicazione. I trasgressori vengono eliminati dal programma, ma non dalla piattaforma e possono presentare ricorso per essere reintegrati. I ricorsi vengono elaborati da un team separato da quello che esegue l’applicazione ed effettua solo controlli di base prima di reintegrare l’attore. Di conseguenza, possono essere necessarie solo ore prima che una fabbrica di troll si rimetta in moto.

È così che Rio si è trovata in uno stato di panico nel marzo di quest’anno. Un mese dopo che i militari avevano arrestato l’ex leader democratico Aung San Suu Kyi e preso il controllo del governo, i manifestanti stavano ancora scontrandosi violentemente con il nuovo regime. I militari stavano tagliando sporadicamente l’accesso a Internet e alle reti di trasmissione e Rio era terrorizzata per la sicurezza dei suoi amici nel paese.

Ha iniziato a cercarli nei video di Facebook Live. “Le persone guardavano molto attivamente questi video perché è così che si tiene traccia delle persone care”, spiega. Non era preoccupata di vedere che i video provenivano da pagine con problemi di credibilità perché credeva che gli streamer stessero usando pagine false per proteggere il loro anonimato. Poi è successo l’impossibile: ha visto lo stesso video in diretta due volte. Lo ricorda perché il filmato era impressionante: centinaia di ragazzini, che sembravano avere non più di 10 anni, in fila con le mani sulla testa, caricati su camion militari.

Quando ha approfondito, ha scoperto che i video non erano affatto in diretta, ma erano stati scaricati da altrove e ritrasmessi su Facebook utilizzando strumenti di terze parti per farli sembrare livestream. Ce n’erano centinaia, che avevano accumulato centinaia di migliaia di visualizzazioni. All’inizio di novembre, “MIT Technology Review” ha trovato dozzine di falsi video live duplicati. Facebook ne ha eliminati molti dopo che sono stati portati alla sua attenzione, ma ne rimangono ancora decine di altri, così come le pagine che li hanno pubblicati. Osborne ha affermato che l’azienda è a conoscenza del problema e ha ridotto significativamente la loro distribuzione nell’ultimo anno.

Ironia della sorte, secondo Rio, i video sono stati probabilmente estrapolati da filmati della crisi caricati su YouTube come prova della violazione dei diritti umani. Le immagini, in altre parole, provengono davvero dal Myanmar, ma sono state tutte inviate dal Vietnam e dalla Cambogia. Nell’ultimo semestre, Rio ha tracciato e identificato diversi gruppi di falsi video in diretta dal Vietnam e dalla Cambogia per accrescere rapidamente il loro numero di follower e spingere gli utenti a unirsi a gruppi di Facebook travestiti da comunità a favore della democrazia.

Rio ora si preoccupa che l’ultima implementazione di Facebook di annunci in-stream nei video live incoraggerà ulteriormente i creatori di troll a falsificarli. Un cluster cambogiano di 18 pagine ha iniziato a pubblicare disinformazione politica altamente dannosa, raggiungendo un totale di 16 milioni di contatti e un pubblico di 1,6 milioni in quattro mesi. Facebook ha rimosso tutte le 18 pagine a marzo, ma nuovi cluster continuano a crescere mentre altri rimangono.

Per quanto ne sa Rio, questi creatori di troll vietnamiti e cambogiani non parlano birmano. Probabilmente non capiscono la cultura birmana o la politica del paese. La realtà è che non ne hanno bisogno, almeno non quando rubano il loro contenuto. Da allora Rio ha trovato molti dei gruppi Facebook e Telegram privati dei cambogiani (uno con più di 3.000 individui), nei quali si scambiano strumenti e suggerimenti sulle migliori strategie per fare soldi. “MIT Technology Review” ha esaminato i documenti, le immagini e i video che ha raccolto e ha assunto un traduttore Khmer per interpretare un video tutorial che guida gli spettatori passo dopo passo alla creazione di fake.

I materiali mostrano come gli operatori cambogiani raccolgono ricerche sui contenuti più performanti in ciascun paese e li plagiano per i loro siti web acchiappaclic. Una cartella di Google Drive condivisa all’interno della community contiene due dozzine di fogli di calcolo di collegamenti ai gruppi Facebook più popolari in 20 paesi, tra cui Stati Uniti, Regno Unito, Australia, India, Francia, Germania, Messico e Brasile.

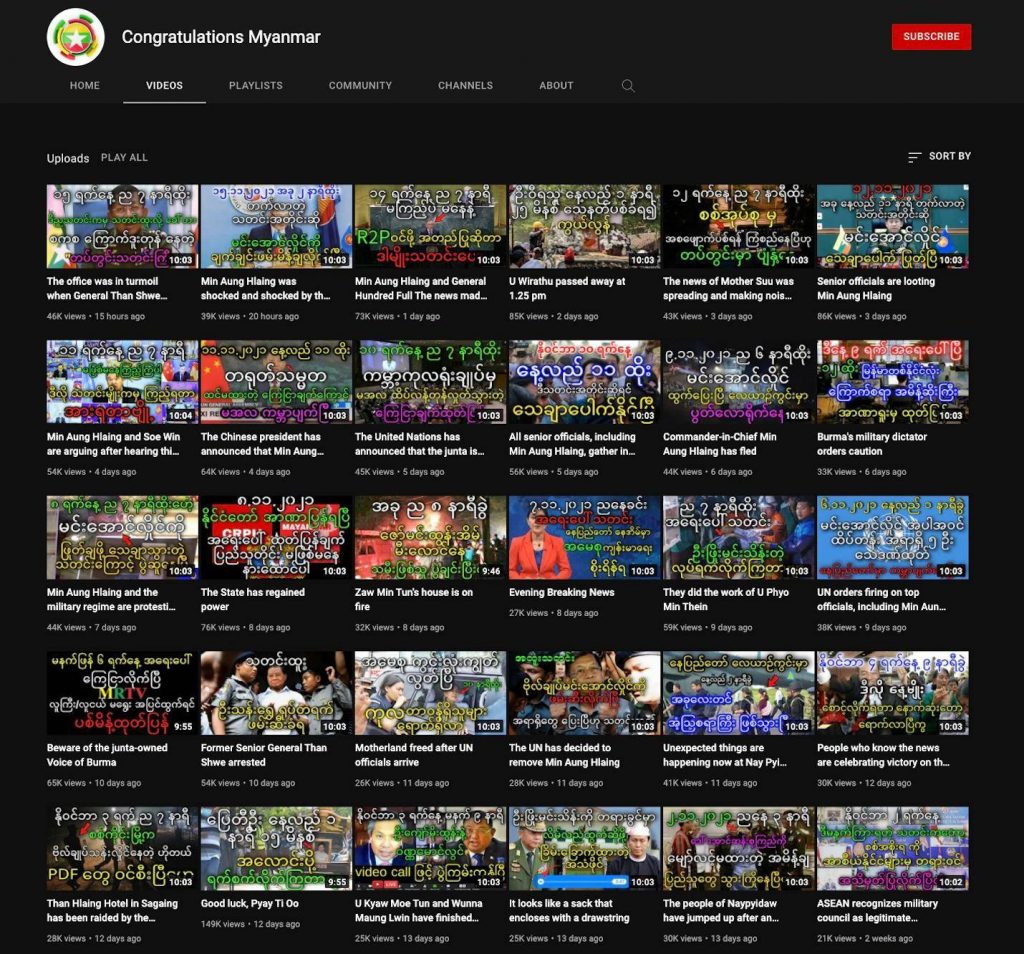

Il video tutorial mostra anche come trovare i video YouTube più virali in diverse lingue e utilizzare uno strumento automatizzato per convertirli in un articolo per il loro sito. Sono stati trovati 29 canali YouTube che diffondevano disinformazione politica sull’attuale situazione politica in Myanmar, per esempio, che venivano convertiti in articoli acchiappaclic e ridistribuiti a un nuovo pubblico su Facebook (si veda figura 8).

Dopo aver portato all’attenzione dell’azienda i canali, YouTube li ha chiusi tutti per violazione delle linee guida della community, inclusi sette che, a suo parere, facevano parte di operazioni di influenza coordinata legate al Myanmar. Choi ha notato che in precedenza anche YouTube aveva smesso di pubblicare annunci su quasi 2.000 video relativi a questi canali. “Continuiamo a monitorare attivamente le nostre piattaforme per evitare che i malintenzionati cerchino di abusare della nostra rete a scopo di lucro”, ha affermato.

Ci sono anche altri strumenti. Uno consente ai video preregistrati di apparire come falsi video di Facebook Live. Un altro genera in modo casuale profili dettagliati, tra cui immagine, nome, compleanno, numero di previdenza sociale, numero di telefono e indirizzo. Un terzo può produrre in serie account Facebook falsi utilizzando alcune di queste informazioni (si veda figura 9).

Ora è così facile farlo che molti attori cambogiani operano da soli. Rio li chiama microimprenditori. Nello scenario più estremo, si parla di 11.000 account Facebook. I microimprenditori di successo stanno anche addestrando altri a svolgere questo lavoro nella loro comunità. “La situazione sta peggiorando”, dice. “Chiunque nel mondo sarà presto in grado di influenzare il tuo ambiente informativo senza che tu te ne accorga”.

Il profitto sulla sicurezza

Durante la sua testimonianza al Senato nell’ottobre di quest’anno, Haugen ha evidenziato i difetti fondamentali dell’approccio basato sui contenuti di Facebook all’abuso della piattaforma. L’attuale strategia, incentrata su ciò che può e non può apparire sulla piattaforma, può solo limitarsi a reagire e a essere lacunosa, ha affermato. Non solo richiede a Facebook di enumerare ogni possibile forma di abuso, ma prevede anche che l’azienda sia abile nella politica di moderazione in ogni lingua. Facebook ha fallito su entrambi i fronti e le persone più vulnerabili al mondo hanno pagato il prezzo più alto, ha spiegato.

Il principale colpevole, ha continuato Haugen, è il desiderio di Facebook di massimizzare il coinvolgimento, che ha trasformato il suo algoritmo e il design della piattaforma in un gigantesco megafono per l’incitamento all’odio e la disinformazione. Un’indagine di “MIT Technology Review” all’inizio di quest’anno, basata su dozzine di interviste con dirigenti di Facebook, dipendenti attuali ed ex, colleghi del settore ed esperti esterni, conferma questa interpretazione.

La sua testimonianza ha anche fatto eco a ciò che Allen ha scritto nel suo rapporto e a ciò che Rio e altri esperti di disinformazione hanno ripetutamente visto attraverso le loro ricerche. Per le fabbriche di troll, entrare nei programmi di monetizzazione è il primo passo, ma quanto incassano dipende dalla misura in cui i sistemi di raccomandazione dei contenuti di Facebook potenziano i loro articoli. Non prospererebbero, né plagerebbero contenuti così dannosi, se le loro losche tattiche non funzionassero così bene sulla piattaforma.

Di conseguenza, estirparle non è la soluzione: attori altamente motivati saranno sempre in grado di creare nuovi siti Web e nuove pagine per ottenere più soldi. Invece, sono gli algoritmi e i meccanismi di ricompensa dei contenuti che devono essere modificati. Nel suo rapporto, Allen ha proposto un possibile modo in cui Facebook potrebbe farlo: utilizzando quella che è nota come una misura di autorità basata su grafici per classificare i contenuti. Ciò amplificherebbe le pagine di qualità superiore come notizie e media e diminuirebbe le pagine di qualità inferiore come gli acchiappaclic, invertendo la tendenza attuale.

Haugen ha sottolineato che il fallimento di Facebook nel difendere la sua piattaforma non è dovuto alla mancanza di soluzioni, strumenti o capacità. “Facebook può cambiare, ma chiaramente non lo farà da sola”, ha detto. “La mia paura è che senza un intervento deciso, i comportamenti divisivi ed estremisti che vediamo oggi siano solo l’inizio. Quello che abbiamo visto in Myanmar e che stiamo vedendo ora in Etiopia sono solo i capitoli iniziali di una storia con un triste finale”.

A ottobre, l’inviato speciale dell’ONU uscente sul Myanmar ha dichiarato che la situazione del paese è degenerata in una guerra civile. Da allora migliaia di persone sono fuggite nei paesi vicini come la Thailandia e l’India. Eppure, a metà novembre, i creatori di troll continuavano a pubblicare notizie false ogni ora: in una la leader democratica, “Madre Suu”, era stata assassinata, in un’altra, che era stata finalmente liberata.

Immagine di: Getty, MIT Technology Review

(rp)